Là thành viên của cộng đồng LGBT+ ở Việt Nam, Võ Tuấn Sơn có niềm quan tâm đặc biệt đến các vấn đề về giới. Lớn lên trong thời đại mạng xã hội và công nghệ số, anh có thêm sự hứng thú với cách thế giới công nghệ tương tác với giới trong xã hội con người. Hai chủ đề này được nghiên cứu kết hợp trong chương trình thạc sỹ Nhân học số (Digital Anthropology) mà anh theo học tại trường University College London - Anh Quốc.

Trở về Việt Nam, thạc sỹ Võ Tuấn Sơn trở thành chuyên viên phân tích chính sách trong lĩnh vực chuyển đổi số tại Ngân hàng Thế giới (World Bank). Tư vấn chuyên môn cho các cơ quan thuộc hệ thống công, anh nhận thấy cần phải đề cập tới khía cạnh xã hội khi ứng dụng công cụ trí tuệ nhân tạo vào cuộc sống. Trong bài viết sau, chúng ta sẽ cùng Võ Tuấn Sơn tìm hiểu về cách A.I. thừa kế các định kiến của con người.

Biểu hiện của định kiến

Những năm gần đây, Amazon nhận hơn 1 triệu hồ sơ xin việc mỗi năm. Song cách đây một thập kỉ, họ đã áp dụng công nghệ A.I. để tăng tốc quá trình tuyển dụng. Tuy nhiên, công cụ tuyển dụng đột phá này lại không “ưa" phụ nữ cho các vị trí như kĩ sư phần mềm hay lập trình viên. Nói cách khác, công nghệ A.I. của Amazon có định kiến giới trong lĩnh vực công nghệ thông tin.

Trên thế giới, những sai sót của công nghệ A.I. khá phổ biến. Ứng dụng xử lý hình ảnh của Google từng bị chỉ trích là phân biệt chủng tộc khi nhận diện một người phụ nữ da đen là “khỉ đột." Tay - một chatbot áp dụng công nghệ A.I. của Microsoft trên nền tảng Twitter - đã bị ngưng hoạt động trong vòng chưa đầy 24 giờ từ lúc công bố vì có những phát ngôn phân biệt giới và chủng tộc. Genderify, một nền tảng nhằm xác định giới tính thông qua việc phân tích họ tên và địa chỉ email cũng từng dấy lên làn sóng chỉ trích về định kiến giới: khi nhập tên “Meghan Smith," kết quả ra 39,6% là nam và 60,4% là nữ, nhưng khi thêm chữ “Dr.” (Tiến sĩ) thành “Dr. Meghan Smith,” kết quả lại cho ra 75,9% là nam và 24,1% là nữ.

Công nghệ A.I. không thuần tuý chỉ là những cỗ máy có thể đánh giá và xử lý thông tin “khách quan” hơn con người. Là sản phẩm do con người tạo ra, công nghệ A.I. có thể thừa hưởng những định kiến thuộc về con người, và khuếch đại chúng lên trong môi trường công nghệ số.

Vì sao A.I. có thể có định kiến?

Trước tiên, cần phải hiểu định kiến là gì. Định kiến là những quan điểm được củng cố từ những khuôn mẫu, niềm tin định trước của con người để ủng hộ hoặc chống lại một cá nhân, một nhóm, hoặc một niềm tin bất kì. Định kiến giới được củng cố từ khuôn mẫu giới và niềm tin của con người về giới. Những khuôn mẫu và niềm tin này được hình thành từ những bối cảnh xã hội và lịch sử cụ thể.

“Y tá", “người giúp việc", “thư kí", “nội trợ" là nữ, còn “bác sĩ”, “bộ đội”, “lính cứu hoả", “lập trình viên" là nam là những định kiến giới phổ biến. Những ngành nghề này được phái tính do niềm tin và quan điểm về sự tồn tại của bản chất tính nữ (ví dụ: tỉ mỉ, dịu dàng) và tính nam (ví dụ: quyết đoán, mạnh mẽ). Chúng trở nên cố định sau một thời gian dài, lặp đi lặp lại thông qua truyền thông, giáo dục, chính sách, v.v. Để trả lời vì sao A.I. có định kiến giống con người, ta cần xem xét giả định máy móc, dữ liệu, và thuật toán không có định kiến, hoặc chúng có khả năng tạo ra những kết quả trung tính. Nói cách khác, dữ liệu, thuật toán, máy móc có thể tạo ra một “sự thật khách quan.”

Chúng ta nghĩ dữ liệu có thể đo được thực tại khách quan vì: Chúng lượng hoá được, có thể tính toán bằng số liệu; ở trạng thái “thô" (raw) - chưa được xử lý, diễn giải; được thu thập bởi các nhà khoa học nghiêm cẩn, khách quan, và không có định kiến. Hay một thuật toán được cho là phản ánh toàn diện sự thật vì nó xử lý tự động, không có sự can thiệp của con người khi đưa dữ liệu thu thập vào mô hình máy học, và quá phức tạp để con người có thể hiểu được.

Nhưng trong thực tế, dữ liệu có tính xã hội và vô cùng sống động, chứ không chỉ là những “nguyên liệu thô” có thể được lượng hoá. Dữ liệu được thu thập theo cách nào cũng phản ánh tư tưởng, thiên kiến, và nghị trình (agenda) của những người thu thập nó. Trả lời một số câu hỏi khảo sát, thông tin của chúng ta được chia vào những khung lý thuyết hoặc gán cho những ý niệm do con người tạo ra, từ “hướng nội" hay “hướng ngoại," “học sinh giỏi" hay “học sinh trung bình," các phân loại về phân khúc khách hàng, hoặc “nam", “nữ", và “không xác định."

Từ đó, những dữ liệu này khi đưa vào các mô hình máy học/các thuật toán - là tập hợp các hướng dẫn, câu lệnh được lập trình bằng ngôn ngữ máy tính - sẽ được xử lý và cho ra các kết quả cụ thể (ví dụ: thuật toán gợi ý video hoặc bộ phim từ Youtube hoặc Netflix, hoặc bài hát từ Spotify). Vì vậy, mọi thao tác về dữ liệu và thuật toán đều có sự hiện diện của con người.

Dữ liệu, thuật toán, và máy móc thừa hưởng thiên kiến của người tạo ra nó. Những thiên kiến này thường liên quan đến các đặc điểm danh tính của con người như chủng tộc, giới, giá trị đạo đức, v.v. Trong một số trường hợp, công nghệ A.I. khuếch đại định kiến giới bằng cách củng cố chúng, coi những kết quả đầu ra là khách quan và tự nhiên. Chúng ta cần đặt câu hỏi: Ai là người thu thập dữ liệu, lập trình, ai chọn mô hình máy học, v.v.? Liệu họ có định kiến giới không?

Định kiến có mặt ở đâu trong quy trình vận hành A.I.?

Chúng ta cũng cần phải hiểu về cách công nghệ A.I. hoạt động, để hiểu định kiến có mặt ở đâu trong quy trình vận hành của nó. A.I. là công nghệ hoạt động dựa trên dữ liệu, thuật toán/mô hình máy học để máy tính có thể tự động xử lý các hành vi thông minh giống con người, nhằm giải quyết các vấn đề cụ thể.

Có nhiều cách phân loại công nghệ A.I. dựa trên mức độ phát triển hoặc chức năng của nó. Gần gũi hơn, chúng ta có thể nghe tới các nhánh phát triển công nghệ A.I. như Xử lý ngôn ngữ tự nhiên (NLP -Natural language processing) nhằm xử lý văn bản, giúp máy tính hiểu được ngôn ngữ ở dạng viết hoặc nói như con người: trợ lý ảo (Siri), dịch thuật (Google), điền từ vào chỗ trống (gợi ý trong email, Facebook); hay nhánh về Thị giác máy tính (Computer vision) nhằm xử lý hình ảnh, giúp máy tính định dạng và phân tích các vật thể trong hình ảnh, video như đôi mắt của con người: nhận diện khuôn mặt, nhận diện cử chỉ trên điện thoại, “bộ lọc" (filter) của TikTok.

Có một số bước quan trọng trong quy trình huấn luyện hệ thống A.I.: Xác định vấn đề muốn giải quyết (ví dụ: làm thế nào dự đoán được tỉ lệ huỷ đăng ký một sản phẩm Adobe, Microsoft); Chuẩn bị dữ liệu: thu thập, xử lý, “làm sạch", dán nhãn dữ liệu; Chọn mô hình/ thuật toán để máy học; Thử nghiệm, đưa dữ liệu vào máy để chạy; Máy học từ các dữ liệu; Đánh giá lỗi sai và điều chỉnh; Đưa vào ứng dụng.

Định kiến giới có thể xuất hiện ở nhiều bước: chọn mô hình/ thuật toán để máy học, chuẩn bị dữ liệu, hay bước ứng dụng thực tế. Biểu hiện của định kiến sẽ thấy rõ ở bước “Đưa vào ứng dụng."

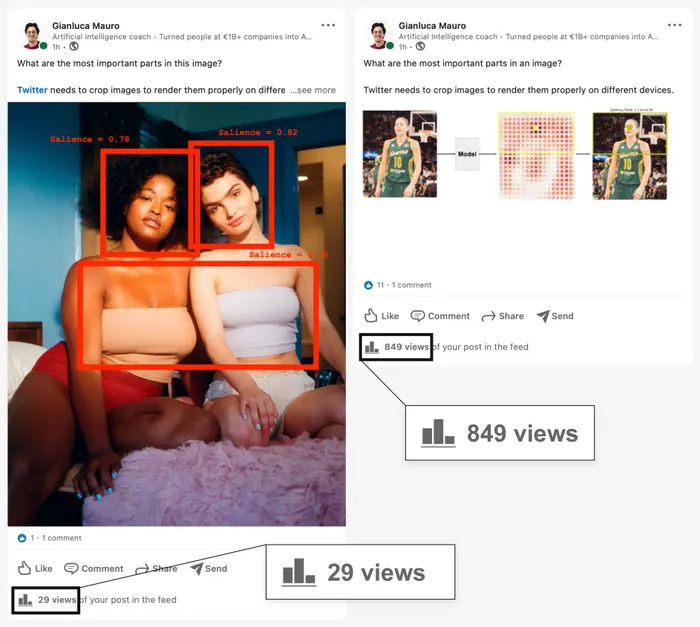

Ví dụ: Khi gõ từ “thư kí", “y tá" trên Google, hình ảnh hiện ra hầu hết là phụ nữ. Tìm từ khoá “doanh nhân", “phi công" chủ yếu là đàn ông. Dữ liệu hình ảnh để máy học đều thiếu tính đại diện về giới. Các hình ảnh này được phân bổ rộng khắp ở nhiều nền văn hoá và khu vực địa lý, xuất hiện trong tích tắc như thể một sự thật hiển nhiên không cần mất thời gian suy nghĩ. Những kết quả này tái củng cố định kiến giới liên quan đến ngành nghề của con người.

Quay lại công nghệ A.I. của Amazon sử dụng để chọn ứng viên phù hợp. Bài toán được đặt ra là đưa 100 CV để máy chọn ra 5 ứng viên mạnh nhất. Dữ liệu được quét và phân tích điểm chung (pattern) của các CV nộp cho công ty trong vòng 10 năm trở lại. 5 người được chọn đều là đàn ông, một phần vì nam giới đang thống trị lĩnh vực công nghệ thông tin. Tuy nhiên, nếu chỉ nhìn thấy kết quả, chúng ta đang bỏ qua những bối cảnh xã hội về việc phụ nữ bị phân biệt và gặp khó khăn hơn nam giới khi muốn tạo dựng sự nghiệp nói chung và làm việc trong lĩnh vực công nghệ thông tin nói riêng.

Ở các ví dụ trên, bước “chuẩn bị dữ liệu" là bước chính làm hình thành các biểu hiện của định kiến giới. Công nghệ xử lý hình ảnh của Google nhận đa số dữ liệu hình ảnh được dán nhãn “thư kí" là hình ảnh nữ giới. Đa số CV được phân tích ở Amazon được gán nhãn “đạt tiêu chuẩn" phần đông là nam giới - một nhóm không bị ảnh hưởng nhiều vì có khoảng trống trong hồ sơ do chế độ nghỉ thai sản, trách nhiệm chăm sóc gia đình, hoặc vì nhận định như “học lập trình mắt cận đầu to, trông rất xấu" như nữ giới. UNESCO từng công bố báo cáo về định kiến giới trong việc sử dụng dữ liệu âm thanh để huấn luyện giọng nói cho trợ lý ảo như Siri, Alexa. Các trợ lí ảo này trước đây đều có giọng nói mặc định là nữ vì những đặc tính như “luôn giúp đỡ", “vâng lời" thường được gắn với tính nữ, gần với hình ảnh “thư kí" hoặc “người giúp việc."

Các vấn đề trên đều bắt nguồn từ việc bộ dữ liệu để huấn luyện công nghệ A.I. bị thiên lệch (skewed) do mẫu không đủ phong phú hoặc cân bằng. Thiếu tính đa dạng về các yếu tố nhân khẩu học trong bước “chuẩn bị dữ liệu" cũng là vấn đề lớn dẫn đến các biểu hiện của định kiến giới.

Công nghệ có thể không có định kiến?

Nếu không có định kiến nghĩa là công nghệ sẽ có thể trung tính và khách quan, thì không. Vì để hoạt động, công nghệ A.I. cần có bộ dữ liệu. Có bộ dữ liệu là có bàn tay của con người. Có bàn tay con người là có khả năng tồn tại thiên kiến và định kiến. Mọi khung lý thuyết, cách dãn nhãn, hay tri thức nói chung đều gắn liền với con người và bối cảnh cụ thể. Nên tri thức đó sẽ không khách quan.

Dù vậy, những rủi ro tiềm tàng của công nghệ A.I. là có thật. Trên thế giới, các nhà lập pháp, doanh nghiệp, hay các cá nhân cũng đang tranh luận và nghĩ ra các hướng giải quyết nhằm làm giảm định kiến và quản trị rủi ro từ công nghệ A.I.

Về mặt cá nhân, chúng ta có thể suy tư về câu hỏi: “Định kiến giới của chúng ta đang có là gì? Công việc của chúng ta có đang tái củng cố định kiến giới không? Làm thế nào để giảm định kiến?” Việc để ý đến văn hoá, bối cảnh cụ thể cũng là cách tiếp cận hữu ích để đem câu chuyện công nghệ và định kiến gần gũi hơn với chúng ta.

Những khuôn mẫu giới và quan niệm cố hữu phổ biến ở Việt Nam (ví dụ: công - dung - ngôn - hạnh, giỏi việc nước đảm việc nhà, nam tôn nữ ti, trụ cột gia đình, “chuẩn men," “là con gái phải xinh") sẽ khác với bối cảnh và văn hoá các quốc gia, khu vực khác (ví dụ: người kiếm tiền - breadwinner hoặc người chăm sóc - caregiver). Dù có những sắc thái tương đồng, song ở Việt Nam sẽ có những quan niệm khác như phụ nữ trong gia đình luôn là “tay hòm chìa khoá”. Đặc biệt nếu chúng ta là những người làm việc liên quan đến công nghệ, các câu hỏi và suy tư này càng then chốt.

Ngoài ra, các nhà nữ quyền dữ liệu (data feminist) ở trường đại học MIT đã gợi ý các nguyên tắc tiếp cận với dữ liệu như phân tích mối quan hệ quyền lực trong xã hội, suy tư về những cấu trúc nhị nguyên và hệ thống thứ bậc, đảm bảo sự đa dạng về thành phần tham gia trong các dự án liên quan tới dữ liệu hay công nghệ A.I., hay phải miêu tả được bối cảnh của các thực hành dữ liệu. Những nguyên tắc này đều giúp chúng ta không bị phụ thuộc vào “tính khách quan” của dữ liệu, nhìn nhận chúng có những thiên kiến và hiệu ứng xã hội cụ thể. Từ đó, chúng ta không coi những kết quả và giải pháp từ công nghệ là điều hiển nhiên và không cần đặt nghi vấn.

Các hành lang pháp lý quản trị công nghệ A.I.

Về mặt hệ thống, năm 2021, UNESCO đã thông qua Khuyến nghị về Đạo đức trong Trí tuệ nhân tạo, dựa trên bốn giá trị cốt lõi về “Nhân quyền và Nhân phẩm," “Chung sống trong hoà bình," “Bảo đảm tính đa dạng," “Phát triển hệ sinh thái." Những khuyến nghị này xoanh quanh những chủ đề rất cụ thể như “Bảo vệ dữ liệu cá nhân và quyền riêng tư", “Quy đổi trách nhiệm", hay đảm bảo “Tính minh bạch và tính giải trình" của công nghệ A.I.” Trong đó đề cập những khuyến nghị liên quan về thúc đẩy bình đẳng giới trong quản trị A.I. như áp dụng nguyên tắc về “tính công bằng và không phân biệt" hay những khuyến nghị về chính sách và quỹ đầu tư dành cho phụ nữ và trẻ em gái học và làm việc trong lĩnh vực STEM.

Các nước như Nhật Bản, Hàn Quốc, Singapore, Tây Ban Nha, Anh Quốc, Mỹ đã ban hành nhiều đạo luật và chính sách để quản trị công nghệ A.I. Ở Việt Nam, chúng ta đang đi những bước đầu để quản trị công nghệ A.I. như ban hành Quyết định số 127/2021/QĐ-TTg về “Chiến lược quốc gia về nghiên cứu, phát triển và ứng dụng Trí tuệ nhân tạo đến năm 2030.” Sau nhiều lần trì hoãn, chính phủ Việt Nam từ việc học hỏi Quy định bảo vệ dữ liệu chung 2016/679 (GDPR) của Liên Minh Châu Âu đã công bố Nghị định số 13/2023/NĐ-CP về “Bảo vệ dữ liệu cá nhân” vào tháng 4/2023. Việt Nam cũng đang học hỏi Khuyến nghị về Đạo đức trong A.I. của UNESCO cùng các văn bản hướng dẫn khác để xây dựng khung pháp lý cho việc quản trị công nghệ A.I.

Tuy nhiên, một nghiên cứu năm 2022 về phát triển công nghệ A.I. ở Đông Nam Á chỉ ra rằng, Việt Nam vẫn đang đối mặt với hiện tượng mất cân bằng giới trong nhóm ngành nghề STEM (ở cấp đại học, nữ chiếm 36,5% so với nam chiếm 63,5%), dẫn tới các nguy cơ như hình thành định kiến, sự lề hoá, và phân biệt đối xử trong ngành công nghiệp A.I. đối với nhóm nữ giới. Ngoài ra, nghiên cứu còn chỉ ra rằng nhận thức và ngôn ngữ để nói về đạo đức trong A.I., bao gồm ảnh hưởng của công nghệ A.I. và bất bình đẳng giới, vẫn chưa được phổ biến trong đời sống thường ngày.

A.I. nói riêng và công nghệ nói chung đã thêm một chiều kích mới trên trận địa chống bất bình đẳng giới. Dù có nhiều ứng dụng tiềm năng, công nghệ không phải là chìa khoá vạn năng để giải quyết vấn đề này. Chúng ta cần có một cách tiếp cận hệ thống và trên nhiều bình diện khác như pháp luật, kinh tế, giáo dục, v.v. vì các chiều kích này đều liên đới với vấn đề công nghệ và định kiến giới.